-

Con estas medidas de contenido sintético o modificado, Twitter espera poner también más información contextual a los posts

-

Aquellas publicaciones que sean identificadas como riesgosas por la red social, mandarán alertas al dar Me gusta o Retweet

-

De esta forma, se espera que se pueda reducir su visibilidad y limitar cuántas recomendaciones recibe del público

En términos generales, el contenido puede tener un efecto muy positivo para empresas y grupos. Permite a las organizaciones a crear una interacción más dinámica con su comunidad en redes sociales. También puede ayudar a generar un vínculo más cercano entre la compañía y su misma plantilla de colaboradores. Además, son una oportunidad de negocio muy valiosa. En buena parte, porque permite colocar mensajes publicitarios y vender productos a la gente.

Sin embargo, estas mismas características que hacen al contenido una herramienta llamativa le confieren ciertas desventajas en las manos de agentes maliciosos. Según The Conversation, las noticias falsas pueden ser utilizadas para engañar a la población. Investigaciones apuntan que los recursos negativos podrían tener un efecto desastroso en el desarrollo emocional de los jóvenes. De acuerdo al New York Times, podría contribuir a la radicalización del público.

Así pues, un sinfín de reguladores, grupos civiles y empresas han tratado de librar una batalla en contra del contenido negativo, falso y radical. Al frente de esta guerra, por decisión propia o no, están las redes sociales. Como los canales principales de difusión de información, todas las plataformas del entorno tratan de ver cómo filtrar y eliminar materiales que son vistos como peligrosos. Y sin quitar el derecho a la libre expresión. El más reciente intento viene de Twitter.

Medidas adicionales para contenido manipulado

Con un comunicado, la red social de microblogging anunció una serie de medidas para reducir el impacto de ciertos recursos dentro de su plataforma. Twitter dice que, desde ahora, estará prohibido que los usuarios compartan “contenido sintético o manipulado que pueda causar daño”. Para ello, la compañía podría etiquetar publicaciones que presenten recursos alterados para presentar una visión distinta. Esto, en un esfuerzo por reducir la incidencia de engaños.

Notas relacionadas

- Claves para desarrollar el marketing con Twitter en 2020

- Un mexicano está atrapado en Wuhan y usa Twitter para pedir ayuda

- Twitter resiente la muerte de Kobe Bryant y registra fallas

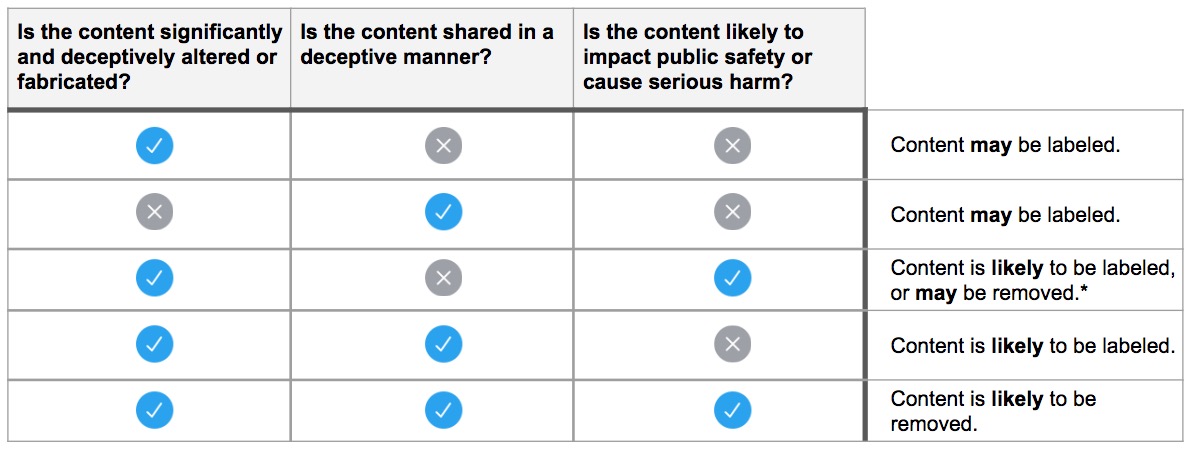

Twitter compartió que habrá tres criterios a considerar al momento de catalogar el contenido potencialmente engañoso. Primero, se evaluará si está manipulado o fue sintético. Después, se analizará si el autor intentó compartirlo con una intención maliciosa o con el objetivo de engañar. Finalmente, se va a decidir si los efectos en la población podrían resultar en un daño serio o si son un peligro a la seguridad pública. Según el caso, podría etiquetarse o removerse.

¿Medida suficiente para prevenir incidentes?

El contenido manipulado, sintético y falso ya ha producido anteriormente resultados no muy agradables. Los deepfakes fueron ampliamente usados para desprestigiar a ciertas personas, algo que ni siquiera Facebook pudo pasar por alto. Con el coronavirus, la desinformación y las fake news están provocando la aparición de teorías de la conspiración. Hace unos meses se presentó un incidente en LinkedIn, donde se usaron estos recursos para tareas de espionaje.

De inicio, las políticas de Twitter parecen adecuadas. Con estas medidas, se establece un parámetro más o menos claro de qué representa (o no) un contenido de riesgo. También ayuda a que las personas no solo dejen de ver estos recursos, sino que les da las herramientas para saber exactamente por qué son un riesgo. Por otro lado, conserva la libertad de expresión de los usuarios más radicales, solo borrando las ideas que son claramente dañinas al mercado.

Por otro lado, esta política de contenido falso tiene el mismo problema que el resto de este tipo de ideas: no actúa sino hasta después del hecho. Claro, es muy difícil que Twitter (u otra red social, para ese caso) tenga un sistema que detecte y detenga los posts que violan sus políticas antes de que lleguen al público. Pero con estas medidas, la gente aún puede estar expuesta, aunque sea solo poco tiempo, a los efectos de estas publicaciones.

Mientras no haya otra solución, estas iniciativas bastan. Pero es urgente encontrar un sistema más preventivo para la moderación de contenido.