Actualmente hay más de 120 herramientas diferentes para generación de imágenes con IA, las más famosas son Midjourney, firefly, Stable Diffusion y Dalle-3, las cuales tienen grandes posibilidades para generación de imágenes con todo el detalle deseado. Estas plataformas premiten generar contenido de casi cualquier tipo; algo que la mayoría de los usuarios nunca llegan a notar es la restricción en cuanto al tipo de imágenes y acabados que se pueden hacer, pensando en respetar la privacidad y/o los derechos de autor.

Por ejemplo, si tratamos de crear imágenes de un celebridad en Dalle-3, nos arrojará un mensaje con una advertencia sobre la restricción para generar contenido usando la imagen de alguien más. Esta restricción sirve para que el usuario promedio no haga imágenes que puedan ser usadas como “Fake News”, pero los usuarios avanzados pueden saltar esas restricciones y crear el tipo de imágenes y vides que quieran.

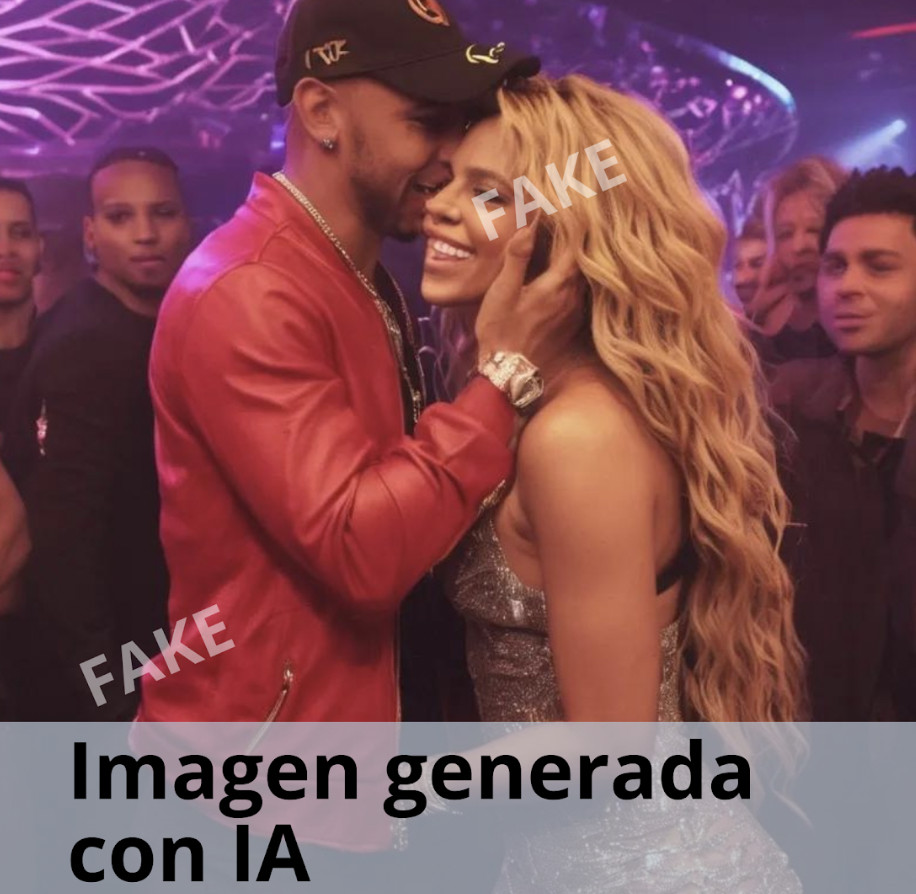

Algunas personas piensan que una vez que se aclara que las imágenes son falsas, se termina el problema; en realidad el daño a la reputación ya está hecho, porque la viralidad en torno a un escándalo por lo general es mayor que la aclaración de lo ocurrido.

Los medios de comunicación ya enfrentan el reto de los “deepfakes informativos”, donde videos e imágenes editadas pretenden mostrar eventos que no ocurrieron. Con la IA, ni siquiera se requiere editar material existente, sino que se puede fabricar evidencia visual de cero con la misma calidad y simulando como si hubiera sido captado en el lugar de los hechos. Esto abre la puerta a campañas de desinformación a gran escala que serían indistinguibles de la realidad para el ojo humano.

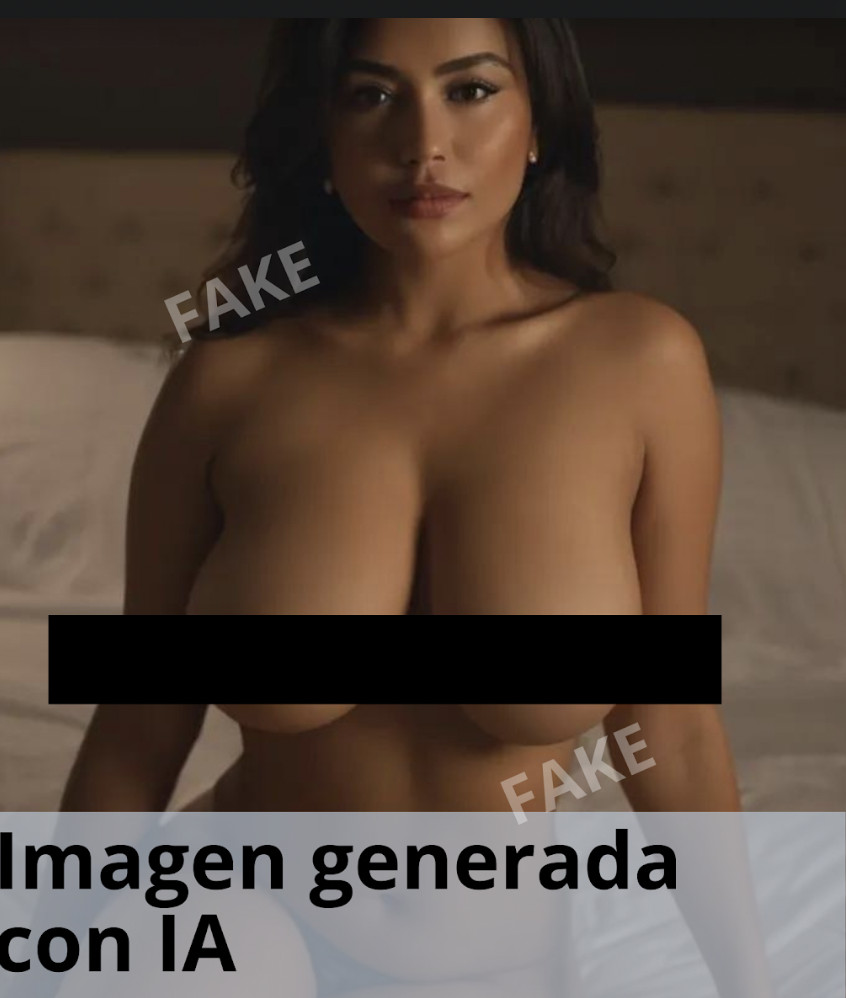

Uno de los usos más controversiales es la generación de contenido sexual explícito no consensuado, conocido como “deepfakes pornográficos”. Estas imágenes y videos hiperrealistas colocan el rostro de una persona en el cuerpo de un actor o actriz pornográfico sin su consentimiento. Esta práctica, además de ser extremadamente dañina para la víctima, es ilegal en muchos países.

Desde una perspectiva legal y de reputación, las imágenes generadas por IA pueden ser utilizadas para crear escenarios falsos que parezcan reales. Esto puede llevar a acusaciones infundadas, difamación y otros daños a la reputación que son difíciles de desmentir debido al realismo de las imágenes. A nivel legal, la dificultad para distinguir entre una imagen real y una generada por IA plantea preguntas sobre la autenticidad y la veracidad, aspectos fundamentales en el derecho y la justicia.

La trazabilidad como posible solución al deepfake

No es fácil implementar procesos de trazabilidad, pero si podría ser una opción viable para distinguir lo real de lo falso.

La trazabilidad se puede aplicar de diferentes maneras:

Métodos de Trazabilidad

- Metadatos Incrustados: Los metadatos son datos insertados en las imágenes. En el caso de las imágenes, los metadatos pueden incluir información sobre la cámara utilizada, la fecha y hora de la captura, y la ubicación geográfica, entre otros. Al analizar los metadatos, se puede obtener una pista sobre el origen de una imagen. Sin embargo, los metadatos pueden ser alterados o eliminados, por lo que no son infalibles.

- Watermarking Digital: Se puede incrustar una marca de agua digital invisible en las imágenes. Estas marcas de agua pueden contener información sobre el creador, la fecha de creación y otros datos relevantes. Incluso si la imagen es alterada, la marca de agua puede permanecer intacta, ayudando a rastrear su origen.

- Blockchain(Cadenas de Bloques): Utilizar la tecnología blockchain para registrar y verificar la autenticidad de las imágenes es un método no tan fácil y económico, pero puede ser efectivo. Cada vez que una imagen se crea o se modifica, la transacción se registra en un bloque de la cadena, proporcionando un historial inmutable y rastreable.

- Huellas Digitales y Hashing: Cada imagen puede ser identificada por una “huella digital” única, una especie de código generado por algoritmos que representan su composición. Si una imagen se altera, su huella digital cambia. Comparando las huellas digitales, se puede detectar si una imagen ha sido modificada.

- Inteligencia Artificial y Aprendizaje Automático: La IA puede ser entrenada para detectar patrones y anomalías en las imágenes que pueden indicar que hubo alguna manipulación. Esto incluye alteraciones en la textura, bordes irregulares y discrepancias en la iluminación o sombras.

Como lo menciono más arriba, las herramientas más populares para generación de IA tienen restricciones para generar contenido sensible, pero usuarios experimentados usan otras plataformas y técnicas para crear cualquier tipo de contenido sin restricción. A continuación incluyo algunos ejemplos que hice para ilustrar este artículo.

Celebridades en situaciones raras o comprometedoras

Papa Francisco

El Papa Francisco es una de las figuras públicas con mayor restricción para generar imágenes con IA, así que me di a la tarea de hacer un juego de fotos en situaciones donde el Papa definitivamente nunca estuvo.

Los presidentes y figuras del espectáculo, son personajes con limitaciones en algunas plataformas, por lo atractivo que puede resultar hacerles fake news.

El presidente de Estados Unidos bailando con la primera dama del presidente anterior)Melania Trump)

BIDEN1.png

Lewis Hamilton tomando en un bar y celebrando con Shakira

Deepfakes pornográficos

Esta es una de las corrientes de generación de imágenes con IA que más ha crecido, sobre todo en Only Fans y paltaformas similares.

El conocimiento que no se comparte, pierde por completo su valor

El conocimiento que no se comparte, pierde por completo su valor