El desarrollo de modelos de inteligencia artificial (IA) ha revolucionado diversas industrias, desde la atención médica hasta el entretenimiento. Sin embargo, detrás del avance de estas tecnologías, existe un desafío significativo que no siempre es visible: el elevado costo de entrenar modelos de IA.

Entrenar una IA avanzada, como los modelos de lenguaje o de reconocimiento de imágenes, implica procesar enormes cantidades de datos en sistemas de alta capacidad computacional. Esto requiere el uso de costosos servidores con potentes unidades de procesamiento gráfico (GPUs) o incluso unidades de procesamiento tensorial (TPUs), diseñadas específicamente para manejar las intensas cargas de trabajo. Empresas como OpenAI, Google y Microsoft invierten millones de dólares en la infraestructura necesaria para este tipo de operaciones.

Por ejemplo, el entrenamiento de GPT-3, uno de los modelos de lenguaje más avanzados hasta la fecha, tuvo un costo estimado de varios millones de dólares, considerando tanto los recursos computacionales como el personal especializado. A medida que los modelos crecen en complejidad y tamaño, también aumenta el tiempo que se necesita para entrenarlos, lo que se traduce en más energía consumida y mayores costos operativos.

Además del gasto en hardware y energía, los costos también incluyen el desarrollo continuo y la optimización de los algoritmos. Los equipos de ingenieros y científicos de datos trabajan constantemente para ajustar los modelos, mejorar su precisión y minimizar errores. A esto se suma la necesidad de almacenar grandes cantidades de datos para entrenar y mejorar la IA, lo que requiere una inversión significativa en centros de datos.

Estos altos costos han comenzado a generar preocupación en la industria, ya que solo unas pocas empresas con grandes recursos financieros pueden permitirse desarrollar y mantener estos sistemas. Esto plantea preguntas sobre la equidad y la accesibilidad de la IA, así como sobre el impacto ambiental de mantener gigantescas granjas de servidores funcionando sin parar.

Si bien el entrenamiento de modelos de IA es costoso, también ha dado lugar a soluciones innovadoras, como la creación de modelos más eficientes y el uso de métodos de entrenamiento más sostenibles. Empresas y startups están buscando maneras de reducir la huella energética de la IA mediante técnicas como el “aprendizaje por transferencia” y la utilización de modelos preentrenados, que permiten ahorrar tiempo y costos.

En definitiva, el alto costo de entrenar modelos de IA es un desafío que la industria debe enfrentar para garantizar un desarrollo más equitativo y sostenible de estas tecnologías que, sin duda, seguirán transformando el mundo en los próximos años.

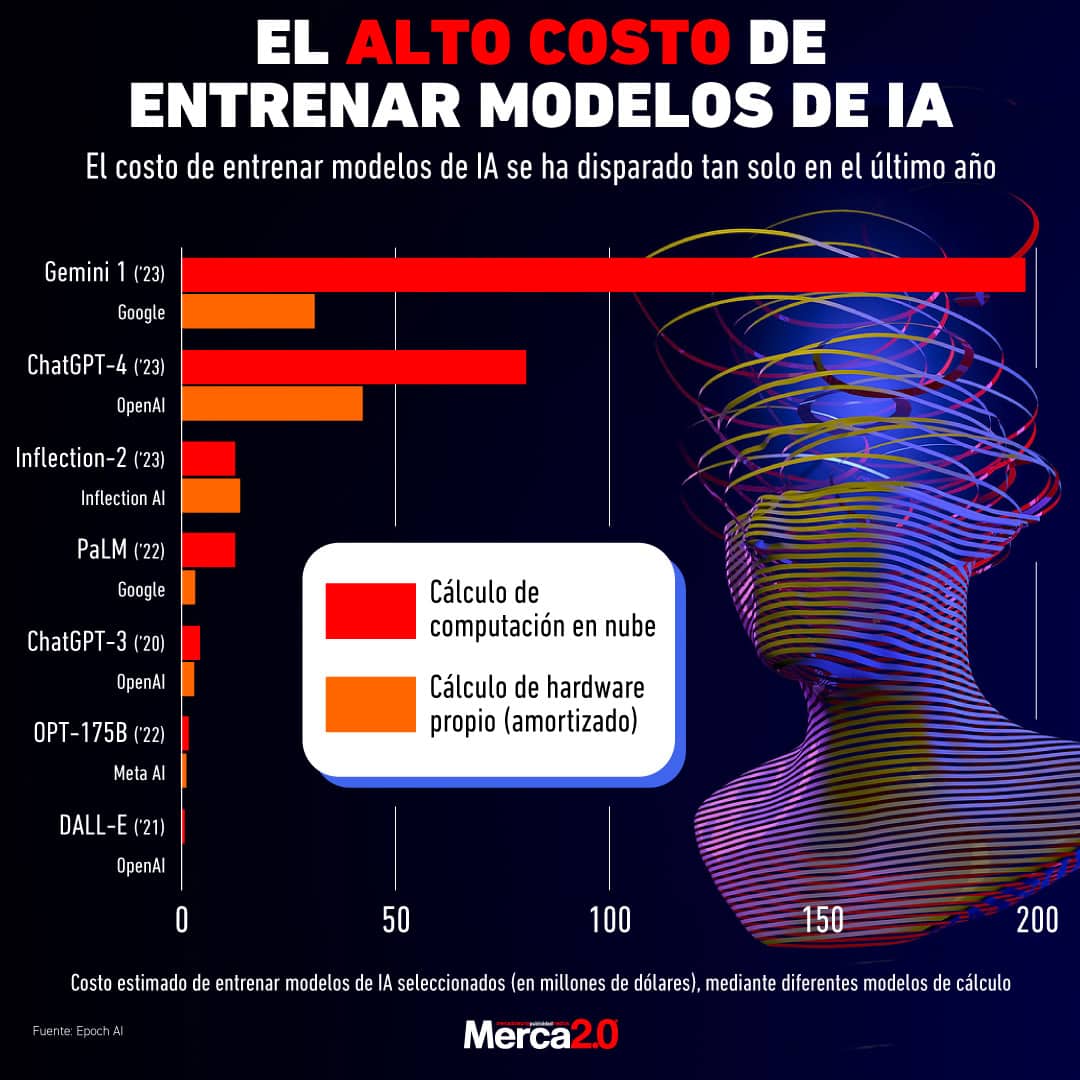

El costo de entrenar modelos de inteligencia artificial ha aumentado drásticamente en el último año, según datos de la firma de investigación Epoch AI. Esto refleja la creciente complejidad y capacidad de estos sistemas. En 2023, OpenAI lanzó ChatGPT-4 en marzo, seguido por Google con su modelo Gemini en diciembre, ambos con costos de desarrollo significativamente superiores a los de modelos anteriores.

El entrenamiento de Gemini costó entre 30 y 191 millones de dólares, sin contar los salarios, que pueden representar hasta el 49% del total. Por su parte, ChatGPT-4 tuvo un costo estimado de entre 41 y 78 millones de dólares, con su director ejecutivo, Sam Altman, confirmando que superó los 100 millones en total.

En comparación, el entrenamiento de modelos anteriores fue mucho más económico: ChatGPT-3 costó entre 2 y 4 millones en 2020, y el precursor de Gemini, PaLM, entre 3 y 12 millones en 2022. Este aumento de costos plantea desafíos para instituciones académicas y públicas que tradicionalmente han liderado la investigación en IA.

La diferencia en los costos también se debe a los enfoques técnicos. Mientras ChatGPT-4 comenzó centrado en texto y luego se amplió a voz e imágenes, Gemini fue diseñado desde el inicio como un modelo multimodal, lo que explica su mayor costo inicial.