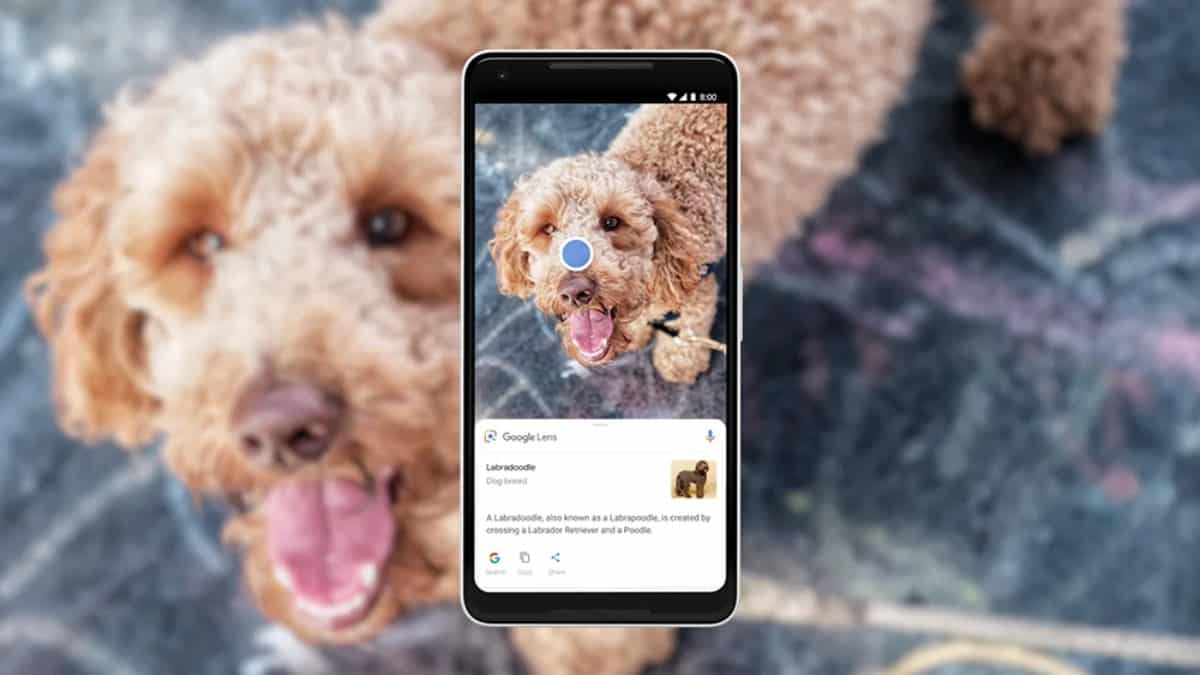

Google Lens, la herramienta de búsqueda visual que ha conquistado a los usuarios de Android desde su debut en 2017, finalmente ha llegado al ecosistema de Apple con una integración que promete transformar la experiencia de los usuarios de iPhone y iPad. Anunciada este miércoles, esta actualización introduce funciones aclamadas como una de las joyas de la corona de Android, adaptadas ahora a iOS mediante las aplicaciones de Google y Chrome. Aquí te contamos los puntos más destacados de esta novedad que combina inteligencia artificial, realidad aumentada y gestos intuitivos para buscar información directamente desde la pantalla.

La nueva función de “Screen Search” en iOS de Google Lens

El principal atractivo de la llegada de Google Lens a iOS es la capacidad de realizar búsquedas visuales instantáneas sin necesidad de capturas de pantalla ni pasos adicionales. Según el anuncio oficial de Google, los usuarios de iOS ahora pueden usar Google Lens para resaltar, dibujar o tocar cualquier elemento en su pantalla, ya sea texto, imágenes o gráficos, dentro de la app de Google o el navegador Chrome. Esta funcionalidad, conocida como “Screen Search”, toma inspiración directa de “Circle to Search”, una característica lanzada en Android en 2024.

En iOS, basta con acceder al menú de tres puntos y seleccionar “Search Screen with Google Lens” para activar esta herramienta. Google también ha prometido que pronto habrá un ícono dedicado en la barra de direcciones de Chrome para simplificar aún más el acceso, haciendo de la búsqueda visual una experiencia más fluida y directa.

Búsquedas mejoradas con texto e imágenes de Google Lens

Otro de los grandes avances de Google Lens en iOS es su integración de texto e imágenes en una sola búsqueda. Esta capacidad eleva la precisión de los resultados, ya que ahora los usuarios pueden combinar elementos visuales con descripciones textuales para obtener resultados más específicos. Por ejemplo, si ves una camiseta en una página web y quieres encontrarla en otro color, puedes tomar una foto con Lens y agregar una descripción como “camiseta roja”.

La inteligencia artificial de Google procesará tanto la imagen como el texto para ofrecer resultados relevantes, acompañados, en algunos casos, de “AI Overviews”, resúmenes generados automáticamente que explican lo que estás viendo. Esta función, que ya estaba disponible en Android, ahora se extiende a los usuarios de iPhone, cerrando la brecha entre plataformas y compitiendo directamente con herramientas como Visual Intelligence de Apple, lanzada en iOS 18.2 para los iPhone 16.

LEER MÁS: ¿Wrestlemania 41 será transmitido en Netflix? Esto es lo que sabemos del magno evento de WWE

Identificación precisa de objetos y comercio en tiempo real con google Lens

La llegada de Google Lens a iOS también destaca por su enfoque práctico. Los usuarios ahora pueden identificar objetos en tiempo real, como plantas, productos o animales, apuntando la cámara de su dispositivo. Esta función ha sido ampliada con un reconocimiento avanzado gracias a modelos de IA mejorados. Esto permite, por ejemplo, estar en una tienda y, al ver un producto o juguete, tomar una foto y obtener reseñas, precios en otras tiendas y disponibilidad local, todo sin salir de la aplicación.

Este enfoque en el comercio ha sido muy popular en Android y busca ahora captar a los consumidores de Apple, especialmente en un momento donde el comercio electrónico sigue en auge. Esta integración puede facilitar que los usuarios de iPhone hagan compras informadas de manera más ágil, sin tener que recurrir a varias aplicaciones.

Diferencias con las Soluciones de Apple

Sin embargo, no todo es perfecto. A diferencia de Android, donde “Circle to Search” está limitado a dispositivos insignia recientes, la implementación en iOS es más universal, pero requiere que los usuarios naveguen por menús para activarla, al menos por ahora. Aunque Google Lens está disponible en cualquier iPhone o iPad con las aplicaciones actualizadas, algunos usuarios en redes sociales han señalado que la experiencia podría sentirse menos nativa en comparación con las soluciones de Apple, que aprovechan el botón Camera Control exclusivo de sus nuevos dispositivos.

Además, Apple ha restringido su Visual Intelligence a los modelos iPhone 16 y los dispositivos Pro de la serie 15, lo que da a Google Lens una ventaja en accesibilidad, ya que puede funcionar en una mayor variedad de dispositivos.

Competencia en la Búsqueda Visual

La competencia entre Google y Apple en el terreno de la búsqueda visual se intensifica con este movimiento. Mientras Visual Intelligence de Apple ofrece integración con ChatGPT y un diseño optimizado para el ecosistema de Apple, Google Lens apuesta por su experiencia acumulada, con casi 20 mil millones de búsquedas mensuales, y su versatilidad multiplataforma.

La llegada de Google Lens a iOS llega en un momento clave, cuando los usuarios de iPhone están explorando las capacidades de iOS 18.2, lanzado en diciembre de 2024. Este movimiento plantea la pregunta: ¿optarán los usuarios de Apple por la propuesta de Google o seguirán siendo fieles a las soluciones nativas de la compañía?

Disponibilidad y expansión futura de Google

Por ahora, Google Lens en iOS está disponible desde hoy con Chrome 133 y la última versión de la app de Google. Google ha anunciado planes de expansión futura que podrían incluir más idiomas y funciones como búsqueda por video, ya presente en Android. Para los usuarios de Apple, esta es una oportunidad única para probar una de las funciones más queridas de Android, adaptada a su propio ecosistema.

La batalla por la supremacía en la búsqueda visual está más viva que nunca, y este paso de Google podría redefinir cómo los iPhone se conectan con el mundo que los rodea.