¿Cómo decide Facebook que un contenido es apto o no para permanecer en la red social? Hace tres semanas, por primera vez, publicaron los lineamientos que siguen para determinar si un contenido publicado es permitido o no.

El pasado 15 de mayo también lanzaron un informe con números reales que son parte de su Community Standards Enforcement Report, que no es otra cosa más que las normas, medidas y estándares que siguen en la compañía.

Alex Schultz, Vicepresidente de análisis de datos, explica detalladamente cómo miden lo que sucede en Facebook. Pero es importante destacar que las medidas cambias constantemente, así como las metodología de acuerdo al aprendizaje sobre lo que es importante y lo que funciona en los usuarios.

El reporte cubre los datos de Enero a Marzo 2018, además de englobar seis áreas clave: violencia gráfica, desnudos, actividad sexual, terrorismo, mensajes de odio, spam y cuentas falsas.

Por lo que los números publicados informan sobre cuánto contenido que viola los estándares es visto por la comunidad de Facebook; cuánto contenido es eliminado por Facebook; y la cantidad de contenido detectado gracias al uso de su tecnología antes de que la comunidad pueda verla o reportarla.

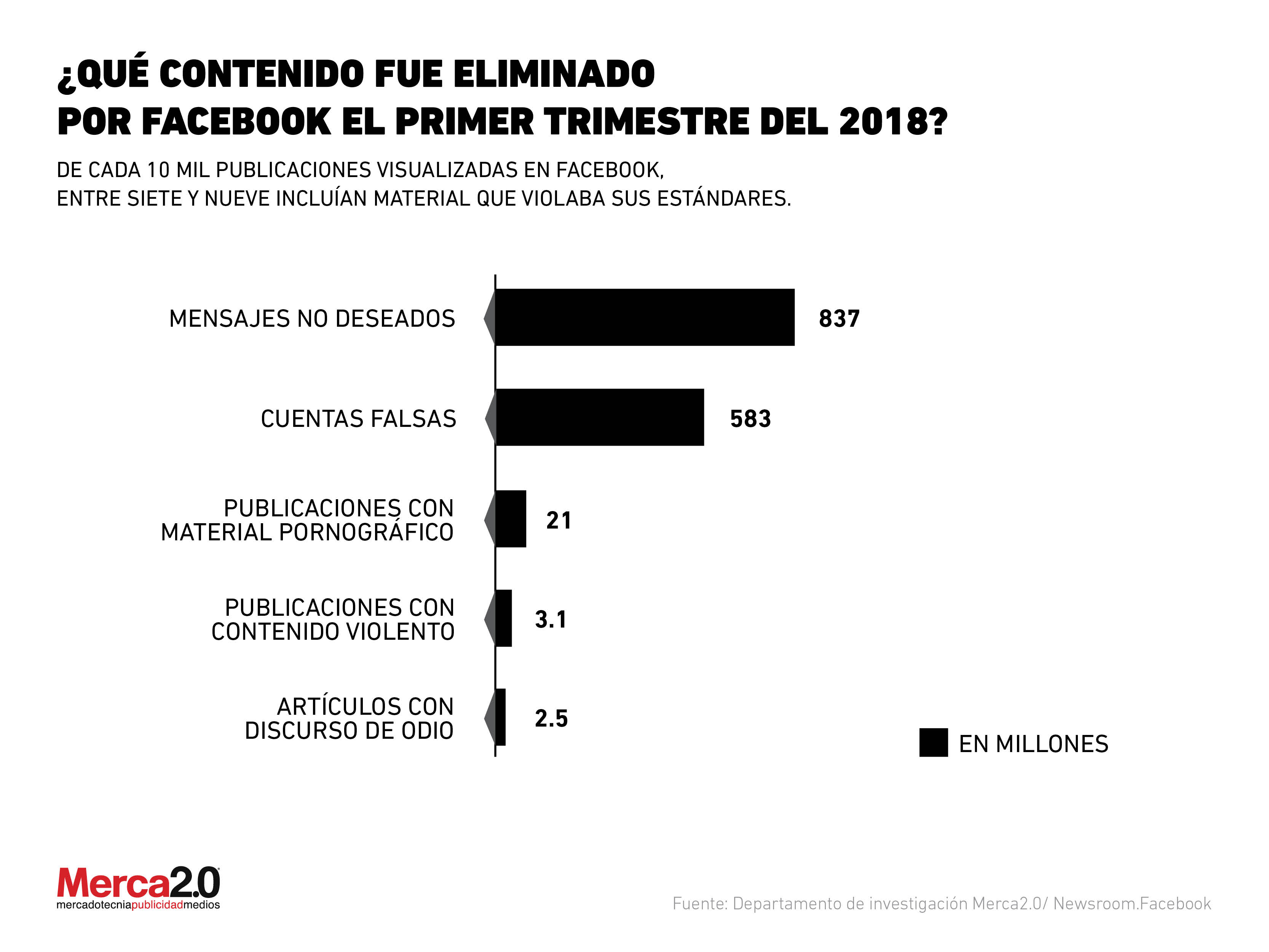

Con respecto al contenido eliminado por Facebook, la mayoría fueron mensajes no deseados ya que se borraron 837 millones; seguidos de las cuentas falsas, pues la compañía eliminó 583 millones.

De igual forma de bajaron de la red social 21 millones de contenidos con material pornográfico, así como contenido violento (2.5 millones de publicaciones). Finalmente se eliminaron 2.5 millones de contenidos con mensajes de odio.