-

Al menos el 62 por ciento de usuarios de internet contemplan a la IA como un riesgo, según Statista.

-

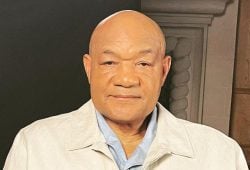

Un hombre denunció a ChatGPT luego de que la herramienta digital lo describiera como un delincuente.

-

Según la UNAM, al menos el 80 por ciento de los usuarios desconoce que utiliza la IA en su día a día.

Un usuario presentó acciones legales en contra de la empresa de ChatGPT, esto luego que la IA lo describiera como una delincuente, así como además que de que habría perpetrado violencia en contra de sus hijos, por lo que decidió actuar en su contra.

De acuerdo a datos expuestos por la UNAM, se encontró que al menos el 80 por ciento de los usuarios desconoce que usa la IA en gran parte del tiempo, mientras que en un 62 por ciento se siente preocupado por el uso de la IA.

Hombre es descrito como delincuente por ChatGPT

Un ciudadano noruego presentó una queja ante la Autoridad de Protección de Datos de su país tras descubrir que ChatGPT lo describió falsamente como un asesino convicto.

La denuncia, impulsada por el grupo de defensa Noyb, acusa a OpenAI de violar el Reglamento General de Protección de Datos (GDPR) de la Unión Europea y solicita sanciones contra la empresa.

Arve Hjalmar Holmen afirmó que, al consultar su propio nombre en ChatGPT, la inteligencia artificial generó una historia completamente falsa en la que lo señalaba como responsable del asesinato de dos de sus hijos y del intento de homicidio de un tercero.

El caso ha reavivado el debate sobre la responsabilidad de los modelos de inteligencia artificial en la difusión de información errónea,

Noyb ya había presentado una denuncia previa contra OpenAI en abril de 2024, cuando ChatGPT reportó incorrectamente la fecha de nacimiento de una figura pública. Sin embargo, este nuevo caso eleva la preocupación sobre el daño potencial que pueden causar respuestas inexactas.

La organización pide que OpenAI no solo elimine el contenido difamatorio, sino que implemente mejoras en su modelo para evitar que se repitan casos similares. Desde la actualización de ChatGPT que permite búsquedas en la web, la consulta sobre Holmen ya no arroja los mismos resultados, sino referencias a la propia denuncia.

El uso de los datos con IA

El uso de datos personales en la inteligencia artificial (IA) es un tema crucial que plantea tanto oportunidades como desafíos éticos y legales. Las empresas utilizan los datos personales para entrenar algoritmos de IA, lo que les permite ofrecer experiencias personalizadas, automatizar procesos y mejorar la precisión de sus servicios.

Estos datos pueden incluir información básica como nombres y correos electrónicos, pero también abarca comportamientos de navegación, historiales de compra y preferencias individuales, lo que permite a las marcas predecir patrones de consumo y ofrecer productos o servicios adaptados a cada usuario.

Un Perro fue el mejor cliente de un 7-Eleven en Taiwan

Sin embargo, el uso de datos personales en la IA plantea preocupaciones sobre la privacidad y la seguridad. Los consumidores, cada vez más conscientes de sus derechos digitales, exigen transparencia sobre cómo las empresas recopilan, almacenan y utilizan su información.

En respuesta, diversas legislaciones como el Reglamento General de Protección de Datos (GDPR) en Europa y la Ley de Privacidad del Consumidor de California (CCPA) buscan garantizar que las organizaciones obtengan el consentimiento informado de los usuarios y limiten el uso indebido de los datos personales.

Spotify

Un ejemplo de cómo las marcas utilizan la IA con datos personales es Spotify, que analiza las preferencias musicales de sus usuarios para crear playlists personalizadas como “Discover Weekly”.

Este enfoque no solo mejora la experiencia del usuario al ofrecer recomendaciones precisas, sino que también impulsa la retención y la fidelización. Al mismo tiempo, la plataforma asegura que los usuarios puedan ajustar sus configuraciones de privacidad, lo que refuerza la confianza y la transparencia en el manejo de sus datos.

Lee también:

Un Perro fue el mejor cliente de un 7-Eleven en Taiwan